回顾Qwen系列

Qwen系列

-

Qwen / Qwen 1.5

-

基础模型:1.8/7/14/72B,后来Qwen 1.5又有0.5/1.8/4/7/14/32/72等。在LLaMA基础上调整,关键策略:

- Embedding and output projection不共享:之前会直接将二者设成互为转置,Qwen改为二者完全独立,提升表示能力

- RoPE,但用FP32(更高精度)存inv_freq(好主意)

- Bias处理:去掉了FFN和layer norms里的bias(提高稳定性、稍微减少参数量,来自PaLM),但在QKV layer(就是)这步加上了bias(来自RoPE)

- Pre-Norm & RMSNorm

- SwiGLU

-

Qwen-Chat:RLHF

-

Qwen-Audio,Code-Qwen,Math-Qwen等

-

Qwen-VL (VLM)

-

visual encoder:ViT(注:仅1.9B,参数大头还是在LLM上)

-

LLM:pretrained Qwen-7B

-

Position-aware Vision-Language Adapter:其实就是单层cross attention,Q可训练,K就是ViT输出,Adapter即可将视觉特征压缩(其实不止压缩,也有投影或对齐的效果)到固定长度(256),这个结果直接进LLM,(感觉其实基本是简化版Q-Former,当然最后像LLaVA直接进一步简化成MLP了)

-

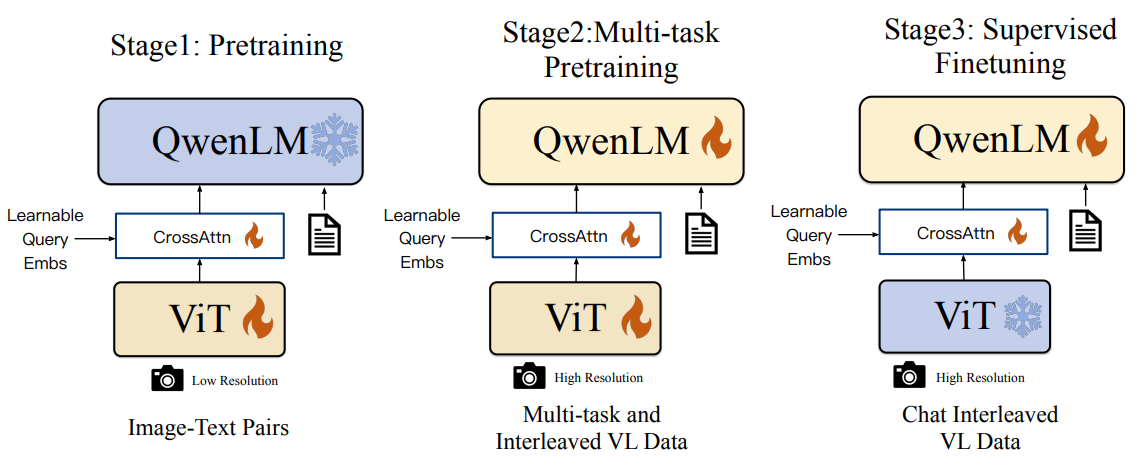

结构图及训练过程(其实很自然):

- 真正的第一步其实是LLM训练;随后冻结LLM训ViT&Adapter,先利用LLM做初步对齐

- 然后就是正常训练,包含LLM在内的全参数均可训练

- 随后指令微调,由于和视觉无关故冻结ViT

-

Qwen1.5-MOE

- 看起来和普通MoE差不多,就是FFN(FFN参数量一般大于Attention部分)换成MoE

-

-

-

Qwen2

- 基础模型

- Qwen2-Instruct

- Qwen2-Math

- Qwen2-VL

- Qwen2-Audio

-

Qwen2.5

- 基础模型

- Qwen2.5-Instruct

- Qwen2.5-Math

- Qwen2.5-Coder

- QVQ

- QwQ

- Qwen2.5-VL

- Qwen2.5-Omni

-

Qwen3

- 基础模型

- Qwen3-Embedding

- Qwen-Image,Qwen-Image-Edit

- Qwen3-Next

- Qwen3-Omni

- Qwen3Guard

- Qwen3-VL

- Qwen3-Coder

- Qwen3-Max

- Qwen-Long