简要说明in-context learning是怎么一回事。主要参考ACL’24

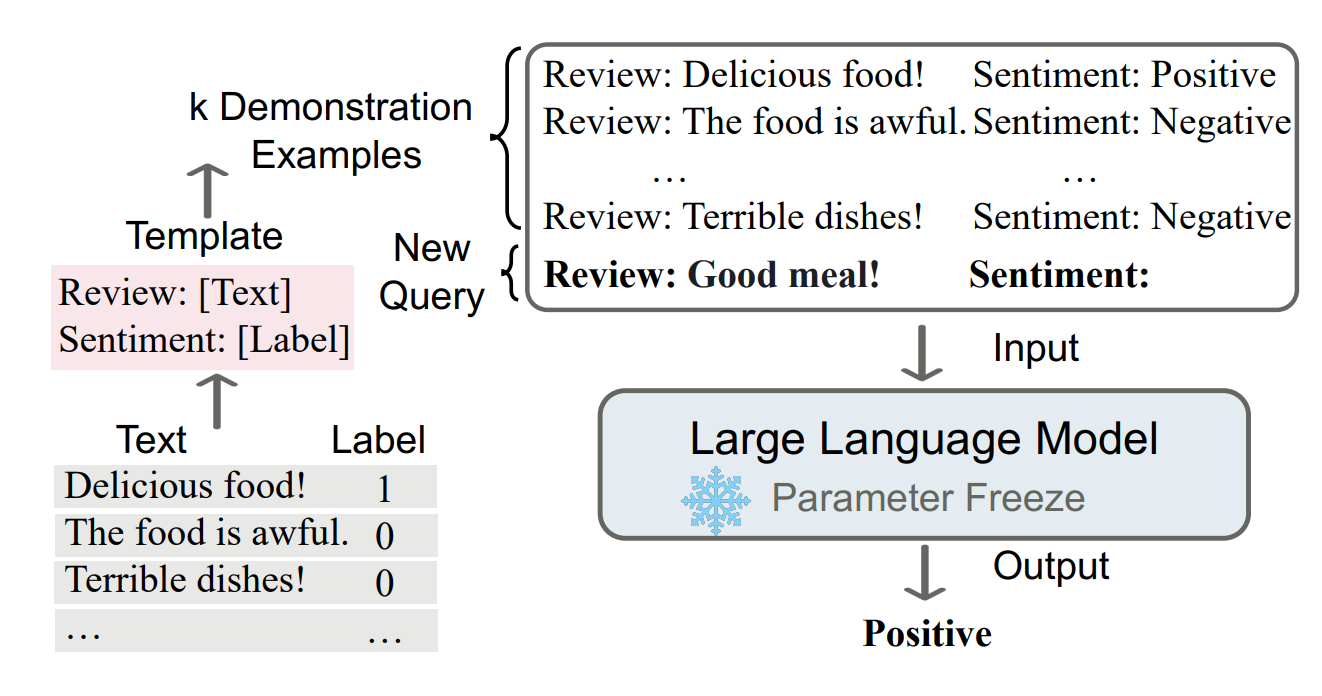

in-context learning就是直接向LLM提供一些(类似)自然语言书写的样例后,LLM可以在不更新参数的情况下(i.e.直接inference的过程中)学习这些样例(注意template是生成或人构造examples时使用,并不输入LLM;NIPS 2020有更公允的定义)。

ICL和prompt learning的区别是,ICL不需要prompt中的那种template,或者可以把输入的自然语言当成prompt,从而认为ICL是prompt learning的一种。ICL和few-shot learning的区别是,ICL不需要更新任何参数。

ICL的效果可能与训练目标有关。一般性的warmup和ICL关系不太大,但一些专门为ICL设计的warmup是有效的,并且给的样例过多会有边际递减。当然,ICL也和demonstration的处理有关。

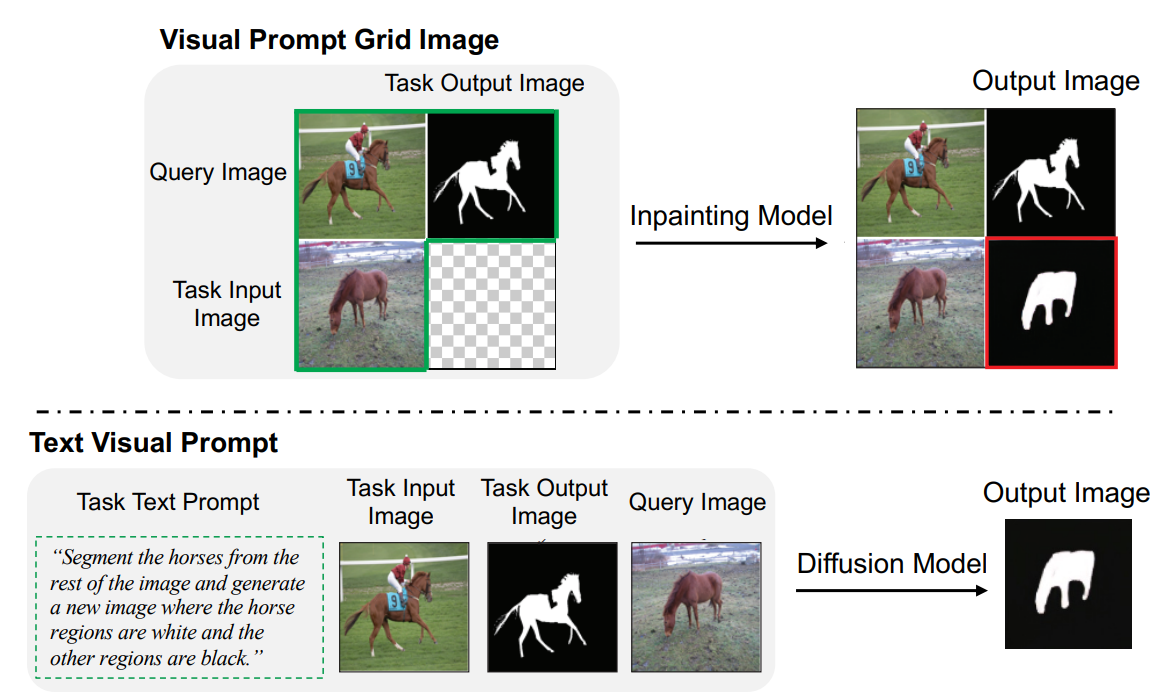

在multi-model或其他的生成式模型中也有类似ICL的现象。例如Diffusion中也有ICLACL’24: